曲建仲说明,NVIDIA的产品核心可分为GPU、CPU与DPU三大类。其中,GPU擅长处理大量、重复的平行运算,是类神经网路训练的主力;CPU则负责作业系统与应用程式,任何具备OS与App的系统都不可或缺;DPU则专责网路、通讯与资安相关工作,是伺服器对外连线的关键元件。在资料中心架构上,机柜内属于「向上扩展」(Scale Up),机柜之间则是「向外扩展」(Scale Out),后者高度仰赖高速交换器的支撑。

他进一步指出,目前主流交换器仍以电交换为主,即便外部传输使用光纤,内部交换仍需进行光电转换,要把光转成电,交换完再把电转成光。在资料中心中反复进行光电、电光转换,导致整体能耗偏高,要一直大量的光转电、电转光,转来转去,每一个转换都是能源浪费。

在运算架构方面,曲建仲比较GPU与TPU的差异。他指出,GPU的最大优势在于高度可程式化,工程师可以撰写程式,让GPU执行各种不同任务;相较之下,TPU则属于专用加速器,其核心为脉动阵列架构,专门用于处理张量运算,但代价是弹性较低,运算如果跟原来能够做的差异太大,就没法做。不过,TPU的效率显著提升,他形容,等于是只要存取记忆体一次,就可以把六次加法做完。

他也点出TPU的市场定位。由于辉达具备完整且成熟的软体生态系,小型客户往往会被其平台绑定;相较之下,Google的TPU多半仅适合大型云端服务商或超大规模资料中心使用,小客户没有能力自己去处理这些软体。

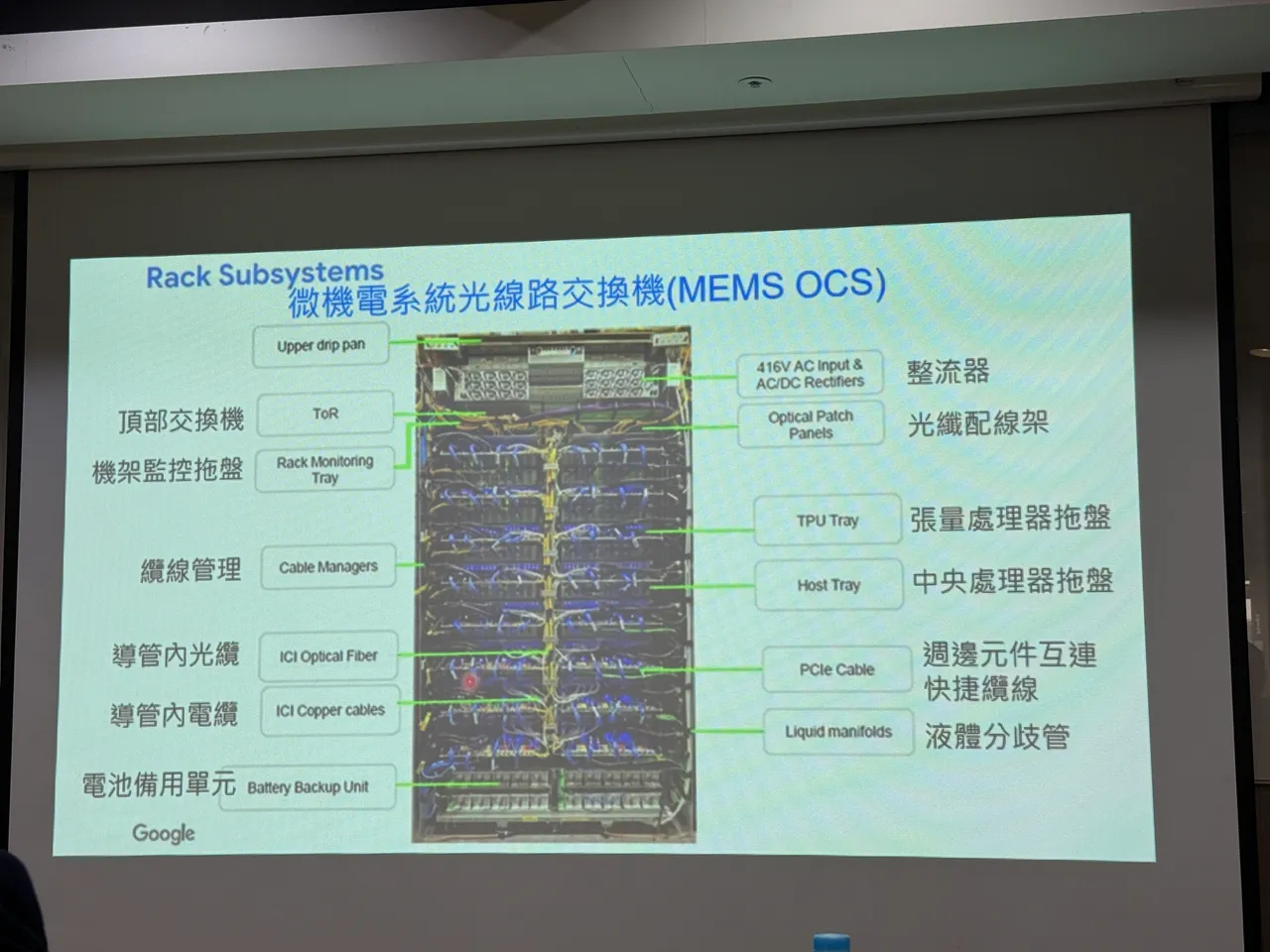

在网路端架构上,曲建仲指出,Google采取与辉达不同的作法,导入「光线路交换机」,也就是不用再转换成电,直接用光传输,核心技术就是透过微机电系统(MEMS)镜片控制光的反射方向。

他也说明,这项技术其实早在20年前就有了,但过去一直难以落地,主因在于传统资料中心必须即时解析封包目的地,无法事先决定资料流向,直到AI训练场景出现,在丢出去之前就已经确定它的目的地了,才能在运算开始前预先设定光路,也就是说,AI伺服器架构成为最适合的应用,这也代表这种技术并不会全面取代既有的交换架构。

曲建仲总结,无论是GPU与TPU,或电交换与光交换,未来都将依照不同应用情境各自找到最适位置,「绝对不会是谁取代谁」,AI的崛起,反而让多年未被广泛采用的技术,终于等到合适发挥的舞台。

點擊閱讀下一則新聞

點擊閱讀下一則新聞