六晶片极端共设计 重构AI超级电脑架构

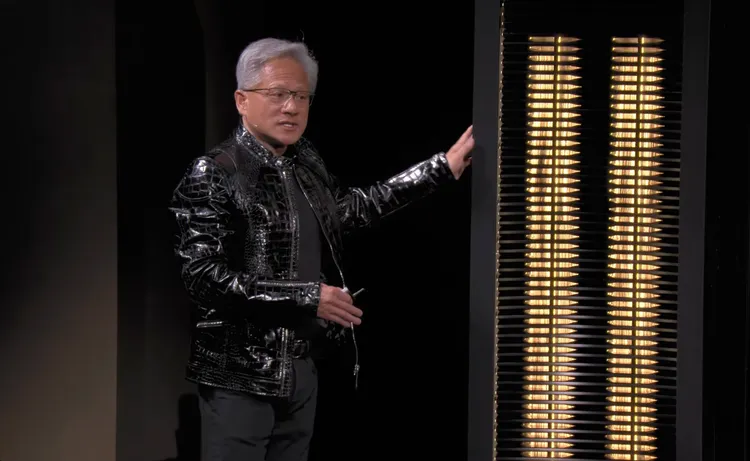

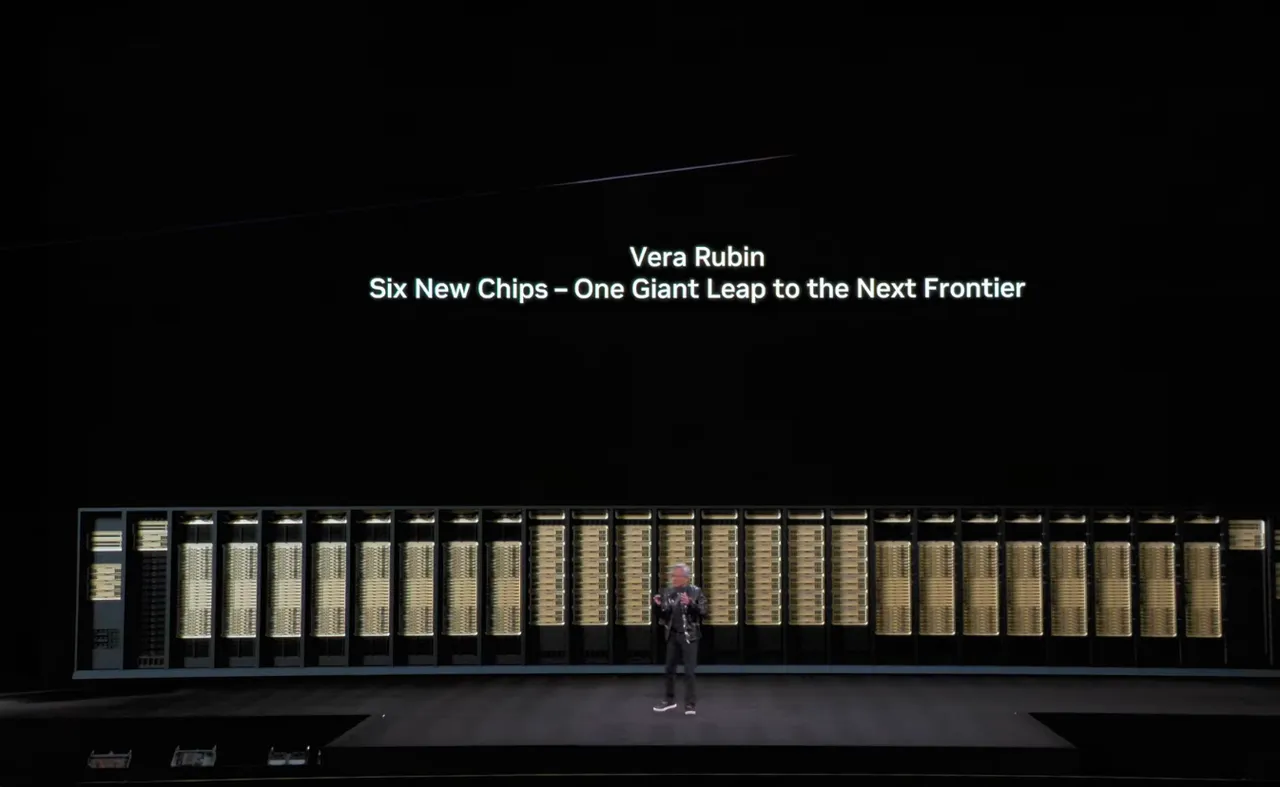

NVIDIA此次于CES 2026发表的Rubin平台,一次推出六颗全新晶片,透过极端共设计(Extreme Codesign)打造完整的AI超级电脑架构,从运算、网路到储存全面重构AI运算堆叠。 NVIDIA指出,相较前一代Blackwell平台,Rubin可将推论token成本最多降低10倍,训练大型MoE模型所需GPU数量减少4倍,为AI进入大规模商用与推理时代奠定关键基础。

Rubin平台由NVIDIA Vera CPU、NVIDIA Rubin GPU、NVIDIA NVLink 6 Switch、NVIDIA ConnectX-9 SuperNIC、NVIDIA BlueField-4 DPU与NVIDIA Spectrum-6 Ethernet Switch组成,横跨晶片、系统与资料中心层级进行整体最佳化。NVIDIA强调,AI的下一个瓶颈不在单点效能,而在整体系统是否能以最低成本、最高效率,支撑长情境、多步推理与agentic AI长时间运作。

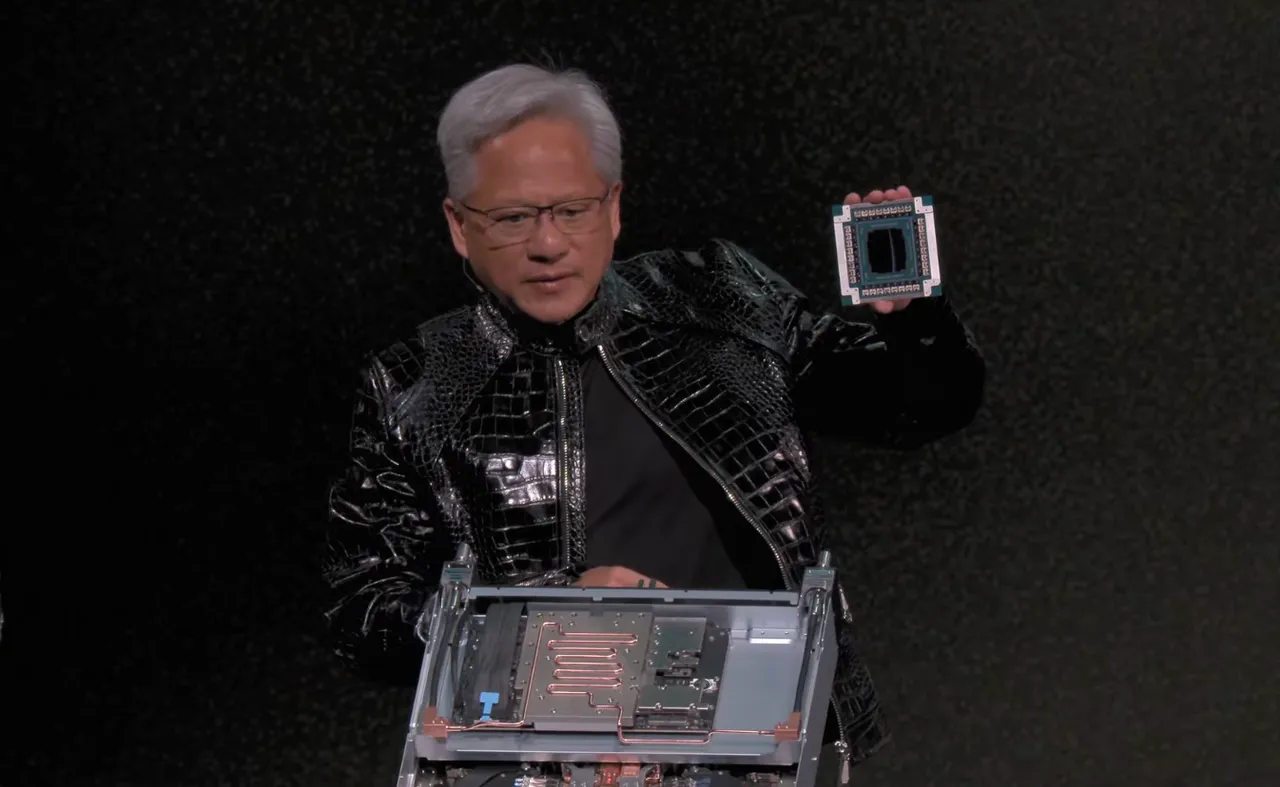

矽光子正式量产 台积电COUPE制程成关键

在关键的光电互连技术上,黄仁勋也特别点名与晶圆代工伙伴的深度合作。他指出,Vera Rubin所采用的新一代Spectrum-X Ethernet photonics交换器,是全球首款进入量产、同时采用矽光子(Silicon Photonics)与共同封装光学(CPO, Co-Packaged Optics)技术的AI乙太网交换晶片,并强调该产品是基于与台积电共同创新、名为COUPE的整合式矽光子制程所打造。

透过将矽光子与光学元件直接导入晶片封装,并在封装层级完成光学与雷射耦合,Spectrum-X得以在单一晶片上提供512个通道、每通道200Gbps的高速传输能力,大幅提升频宽密度与能源效率,为AI资料中心的大规模扩展奠定基础,也宣告AI运算正式迈入以光电整合与CPO为核心的新世代。

点名台湾ODM AI伺服器系统量产关键仍在供应链

值得注意的是,黄仁勋在演讲中特别点名台湾供应链在AI系统建构中的关键角色。他直言,从鸿海、广达、纬创,到HP、Dell Technologies与Lenovo,整个产业链早已具备打造AI超级电脑与大规模系统的能力,凸显台湾ODM体系在全球AI伺服器与高效能运算产业中的核心地位。

在云端与AI服务生态系方面,Rubin亦获得多家重量级业者支持,包括Amazon Web Services(AWS)、Google、Microsoft、Oracle,以及CoreWeave、Lambda、Nebius与Nscale。其中,Microsoft将在其下一代Fairwater AI超级工厂中,大规模部署Vera Rubin NVL72系统,作为Azure新一代AI运算核心。AI模型与应用端如OpenAI、Anthropic、Meta、xAI、Mistral AI、Cohere、Perplexity、Runway与Thinking Machines Lab,也同步看好Rubin在长情境、多模态与推理型模型上的效能与成本优势。

生态系全面到位 Rubin迈向系统级量产落地

NVIDIA表示,包括Anthropic、Black Forest、Cohere、Cursor、Harvey、Meta、Mistral AI、OpenAI、OpenEvidence、Perplexity、Runway、Thinking Machines Lab与xAI等AI实验室,皆看好NVIDIA Rubin平台在训练更大、更强模型上的效能优势,并可在更低延迟与成本下,支援长上下文与多模态系统服务。

在基础设施层,AIC、Canonical、Cloudian、DDN、Dell、HPE、Hitachi Vantara、IBM、NetApp、Nutanix、Pure Storage、Supermicro、SUSE、VAST Data与WEKA等软体与储存合作伙伴,也正与NVIDIA携手,为Rubin基础设施设计下一代平台。

NVIDIA指出,Rubin为其第三代机架级架构,目前已拥有超过80家NVIDIA MGX生态系合作伙伴。为进一步释放高密度运算潜力,Red Hat亦宣布扩大与NVIDIA合作,整合Red Hat Enterprise Linux、Red Hat OpenShift与Red Hat AI,提供针对Rubin最佳化的完整AI软体堆叠,并已广泛应用于多数Fortune Global 500企业。

點擊閱讀下一則新聞

點擊閱讀下一則新聞